L’intuition des scientifiques ou la raison des ingénieurs ? Avec les blogs, réseaux sociaux, sites ou encore chaînes de mails, les fausses informations se répandent à grande vitesse et peuvent facilement être prises pour argent comptant.

Ce n’est pas nouveau, sur Internet on trouve de tout…

Les canulars sur le net sont nombreux et de toute nature. Ainsi le 11 septembre n’aurait jamais existé, le fils de la ministre Christine Taubira serait en prison pour meurtre et EDF nous volerait sournoisement 1€ sur chacune de nos factures…

Tous les canulars ne cherchent pas à être pris au sérieux mais pourtant la plupart d’entre eux sont bien souvent repris par les internautes qui croient en leur authenticité. Pascal Froissart, maître de conférences à l’université Paris 8, explique qu’une « rumeur fonctionne parce qu’on écrit dessus. Les gens croient ce qu’on leur donne à lire, même quand on leur dit que c’est faux.». En ce sens, nous nous souvenons tous, avec plus ou moins de malaise, de Christine Boutin citant le Gorafi pour appuyer ses propos à l’encontre du gouvernement. L’ancienne ministre n’avait pas su voir que le site parodique se moquait dans son article des éléments du langage bureaucratique.

La première intuition n’est pas toujours la bonne

Même si cela est tentant, prévenons-nous rapidement de tirer sur l’ambulance. La problématique soulevée ici est concrète : la première intuition n’est pas toujours la bonne, alors comment détecter le vrai du faux, l’exploitable de l’inexploitable ?

Cette problématique, nous la côtoyons tous les jours dans nos projets. Prenons l’exemple de l’humour. Supposons que vous deviez analyser des données issues d’un réseau social public. Le second degré n’étant pas, par définition, une donnée exploitable par un système d’information vous décidez de filtrer tous les lolcats, les WTF, les tumblrs, les dessins humoristiques et les blagues d’humour.net.

Dans votre tamis, il ne reste que vos données « exploitables » et vous décidez de démarrer vos analyses. En vain. Car, l’humour faisant partie intégrante de la sphère internet, en omettant cette part d’ « infos poubelle », votre observation est d’ores et déjà faussée et vos conclusions le seront tout autant. Parlez-en à Schrödinger, il a fait la même erreur avec son chat…

Question d’intuition…

Ne vous est-il jamais arrivé de produire un tableau de bord avec le sentiment de mettre en évidence de fausses conclusions, de produire des indicateurs à partir de données que vous saviez erronées, tronquées ou de mauvaise qualité ? Allons, ne me dites pas qu’il ne vous est jamais arrivé de critiquer une règle de gestion, de penser en parcourant des spécifications fonctionnelles « C’est débile ! », « On peut faire dire ce qu’on veut à ces chiffres », ou « Cet indicateur n’a aucun sens »…

Toujours pas convaincu ? Prenons un exemple simple. Supposons qu’on me demande de traiter de la répartition géographique d’un ensemble d’agences bancaires sur le territoire français. Je dispose d’un fichier sur lequel figurent le nombre d’agences bancaires et le nombre d’habitants par ville. Fastoche ! J’intègre mon fichier et je représente ces deux attributs sur un modèle Géo-BI. J’obtiens une belle carte de France sur laquelle apparaissent mes agences. Super fastoche !

Mais c’est pas fini

Dans un second temps, on me demande de représenter la densité d’agences par habitant. Hyper fastoche ! Je crée un attribut calculé adimensionnel dans lequel je stocke le quotient « nombre d’agences / nombre d’habitants ». Et là, c’est le drame !

La carte de France démontre une densité d’agence faible dans les grandes villes. L’indice passe de 6 % en couronne périphérique à 3,5 % en centre-ville (soit une diminution de presque 40% !). Qu’en conclure ? Que les grandes villes manquent d’agences bancaires ? Que ce réseau bancaire doit impérativement développer une politique de reconquête des centres villes ? Et que s’il ne réagit pas rapidement, il finira par mettre la clé sous la porte, le couvert sur la marmite et la cabane sur le chien ?

La vérité est ailleurs

La vérité est évidemment ailleurs… Tout simplement, cet indicateur n’a aucun sens car il n’est pas rapproché à la spécificité des agences du centre-ville : leur capacité d’accueil, leur superficie, leur maillage, le nombre de conseillers qui y travaillent. Et quid de l’architecture du centre-ville, des moyens de transport,… J’entends d’ici les « Ah ben oui, mais c’était pas dans les specs ! », ceux-là même à qui on répétait en classe qu’il ne faut pas additionner les choux et les carottes.

Ces approximations qui nous déconstruisent

Ces approximations que nous faisons régulièrement contribuent à alimenter notre quotidien. On voit fleurir ici et là des dizaines d’études qui démontrent tout et son contraire. « Le monde appartient à ceux qui se lèvent tôt. » nous dit le proverbe, sauf qu’une étude britannique rendue publique par « Personnality and Individual Differences », démontrerait plutôt que les gens intelligents se couchent tard et se lèvent, donc, en moyenne, une demi-heure plus tard que les « QI faibles ».

Début novembre 2015, on apprend par des chercheurs finlandais que les gens intelligents non seulement se coucheraient tard, mais qu’en plus ils buveraient plus d’alcool que les autres. Et je ne vous parle même pas de leur consommation de psychotropes !

Par ailleurs, indiquent, encore des chercheurs américains (toujours à la même période), être marié donnerait plus de chances de survivre à une opération cardiaque. Sauf peut-être si on mange beaucoup de viande, puisqu’on sait depuis peu que la consommation de charcuterie accroit probablement le risque de cancer…

Des corrélations certes, mais est-ce toujours vrai ?

Le point commun à chacune de ces études ? Elles sont basées sur des corrélations, des courbes qui montent ou descendent en parallèle, des cartes qu’on superpose et qui peuvent laisser croire à une causalité : un lien direct et évident entre l’alcool et le QI, entre la France « Charlie » du 11 janvier et les zones de déchristianisation récente, entre le saucisson et le cancer colorectal.

Parfois c’est vrai, c’est prouvé. Et parfois, ça a autant de valeur scientifique qu’un reportage sur NRJ12… Allez donc voir la façon dont ces pseudo-études sont tournées en dérision par des universitaires américains. Vous avez les adeptes du sparrowisme, du nom de Jack Sparrow le héros de Pirates des Caraïbes, doctrine qui établit une relation évidente entre la baisse du nombre de pirates dans les mers du globe et la hausse des températures. Moins y a de pirates et plus ça se réchauffe. Logique !

Attention aux fausses conclusions sur des données mal construites

Certes, c’est drôle, mais allez voir : les courbes sont convaincantes, les corrélations troublantes… Essayez de les transposer à des domaines plus complexes auxquels vous êtes confrontés chaque jour – citons le réglementaire financier – et voyez comme la tentation est grande d’établir de fausses conclusions sur des données mal traitées.

Qu’est-ce que j’essaie de démontrer ici ? Qu’il est important, aujourd’hui plus que jamais, d’aiguiser son œil critique, de généraliser le fact-checking, de développer son libre arbitre, d’écouter son intuition et de ne pas se laisser enfermer dans des modèles de pensées prédéfinis. Dans un système complexe, il est « impossible de connaître les parties sans connaître le tout. » écrit Edgar Morin, philosophe et spécialiste du big data dans son livre « Sciences avec Conscience ». On ne comprend pas l’internaute si on ne comprend pas Internet, et il n’est pas possible de comprendre Internet sans comprendre les comportements individuels des internautes.

La technologie progresse mais…

La technologie progresse mais elle est, pour l’heure, insuffisante. Aucun ordinateur au monde n’est, actuellement, capable de traiter l’entièreté de l’information qui est générée au fil du temps. Quand chaque appareil électroménager, téléphone, compteur biométrique, instrument de mesure scientifique, etc. génère chaque seconde de la donnée, il est impensable de vouloir traiter l’entièreté des données à notre disposition.

Analyser ou échantillonner les réseaux sociaux s’avère tout aussi périlleux (je ne parle pas de question éthique). Le caractère des comportements observés y est trop complexe : ces derniers sont trop volatiles, sujets à l’approximation ou aux ressentiments des internautes qui les alimentent.

Devenez sorciers, devenez savants

La première conclusion à tirer de cette analyse est qu’il ne faut en faire aucune. Surtout quand elles sont trop hâtives. La science nous enseigne d’abord la prudence.

Mais, la seconde conclusion est paradoxalement de penser grand ! Ne vous restreignez pas, soyez inventifs, jouez avec vos données.

Ne vous restreignez pas

Au plus vos modèles seront complexes, au plus ils tendront vers la réalité. Dans votre laboratoire, introduisez de l’hétérogénéité : de la profondeur d’historique, des données de géolocalisation, des données météo, des données liées à l’actualité, etc… et, dans votre cornu, mélangez le tout.

Soyez inventifs

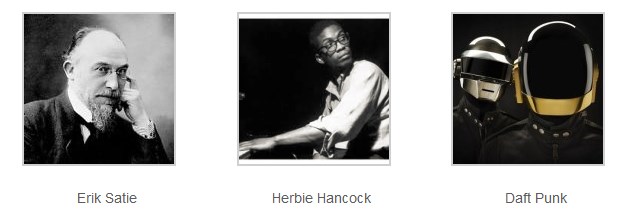

Fuyez les modèles classiques. Une des erreurs du marketing consiste en effet à ne proposer aux consommateurs que des produits basés sur des analyses volumétriques de parcours. « Ceux qui ont aimé X, on également acheté Y ». Or, il suffit pourtant de traîner quelques minutes devant une salle de concert pour comprendre que « ceux » qui écoutent Daft Punk, ont, non seulement, écouté la discographie de DJ Shadow et Nile Rodgers, mais sont également souvent incollables sur Erik Satie et Bach. A l’inverse, ils fuient la musique mainstream et se retrouvent davantage dans l’underground. Pourtant, si vous tapez « Daft Punk » sur un moteur d’achat en ligne, c’est rarement Herbie Hancock qui ressort dans les premières occurrences.

Jouez avec vos données

Amusez-vous, tentez des mélanges contre-nature. L’exemple du second degré comme composante d’analyse mérite, à mon sens, qu’on se penche sur le sujet. Mais n’oubliez pas que jouer, c’est aussi apprendre à perdre. En mélangeant tout et n’importe quoi, attendez-vous à tout faire sauter dans votre labo ! Mais ne baissez pas les bras et surtout recommencez.

Et vous savez quoi ? C’est une bonne nouvelle… Car c’est là toute l’âme de la science et de notre métier. Je ne fais qu’enfoncer le clou en insistant encore lourdement (trop ?) sur un des points que j’avais soulevé précédemment sur ce blog : chez le data scientist, le plus important c’est le scientifique pas le technicien.

Ainsi, notre métier ne consiste pas à aligner des 0 et des 1, à croiser des attributs, à construire des hiérarchies mais à les comprendre et à les relier. C’est cela l’enjeu de la complexité ! Dans le big data, il faut s’attendre à trouver ce qu’on ne cherchait pas. Mais si tu trouves l’Amérique en cherchant l’Inde et que tu t’arrêtes là en concluant que tu as trouvé une route plus courte pour y arriver, c’est que tu as fait fausse route !

![[Data Rider] REX Collecte de données IoT – Étape 1 : Initier la collecte](https://fr.blog.businessdecision.com/wp-content/uploads/2025/05/data-rider-rex-collecte-donnees-1024x512-1.jpg)

Commentaire (1)

Votre adresse de messagerie est uniquement utilisée par Business & Decision, responsable de traitement, aux fins de traitement de votre demande et d’envoi de toute communication de Business & Decision en relation avec votre demande uniquement. En savoir plus sur la gestion de vos données et vos droits.