Jean-Michel Franco, de l’éditeur de logiciels Talend présentait à la Matinale du Big Data 2014 de Business & Decision la méthodologie nécessaire aux projets de Big Data mais aussi sur les défis associés à cette innovation.

Un paysage des données de plus en plus hétérogène

« Le paysage des données d’entreprise est de plus en plus hétérogène” a déclaré Jean-Michel dans son introduction. « Dans un premier temps, les entreprises ont essayé de tout mettre en un même lieu, mais à l’heure du Web social, « les données sont éparpillées partout dans l’Internet” et cela ne simplifie pas les choses. Pour faire face à ce problème, on peut retenir trois grandes gammes de solutions :

- l’intégration de données ;

- l’intégration d’applications et de métiers ;

- la conception de solutions permettant de créer des référentiels et de gérer la qualité des données.

Comment les entreprises abordent-elles les Big Data ?

En matière de Big Data la méthode d’approche consiste à se servir d’un bac à sable (environnement système factice recréé pour effectuer des simulations) avec différentes vues business (marketing, gestion des pannes …). « Ce processus de test peut parfois avoir un côté très industriel” a indiqué Jean-Michel. Dans ce bac à sable, ou sandbox pour les anglophones, on introduira donc un scénario analytique : celui-ci “aura la même allure, en général, qu’un projet plus classique avec de l’analytique. Une fois cette phase de test effectuée et corrigée, l’entreprise passe concrètement à l’action ; c’est à ce moment que l’on peut véritablement parler de transformation. Cette démarche en 3 phases est détaillée dans la présentation mise en ligne par Jean-Michel sur son espace Slideshare.

Matinale du Big Data Talend from Jean-Michel FRANCO

L’exemple d’un distributeur du Nord de la France

Pour préciser cet aspect théorique, prenons l’exemple d’un distributeur du Nord de la France. « La volonté de ce distributeur était de mieux comprendre le marché de la grande distribution en utilisant les Big Data : le groupe a donc mis en place un bac à sable où une plateforme de gestion d’audience (Data Management Platform) a été installée” a expliqué Jean-Michel Franco. Dans ce système, les visiteurs restent anonymes, mais il est toujours possible de connaître les catégories de visiteurs qui viennent sur le site.

Il s’agit d’un système Hadoop lié à la géolocalisation et les données météo. Ce croisement permet d’avoir des résultats approfondis : par exemple observer l’absence de corrélation entre la météo et la fréquentation. Il est en effet habituel de penser que lorsqu’il fait beau les visiteurs sont moins enclins à visiter les magasins, alors que dans la réalité, démontrée par ce système, il n’en est rien. Ce système a également rendu possible l’analyse des clics, qui a ensuite conduit à l’analyse des résultats par client en les croisant avec le Data Warehouse.

Les données ont donc été rapatriées du cloud puis elles ont été comparées aux données des clients pour approfondir la connaissance du consommateur. La troisième étape est encore à l’état de projet : il s’agira en effet de passer à une étape plus opérationnelle, et de connecter ce système aux ad-servers afin de permettre un ciblage publicitaire très fin.

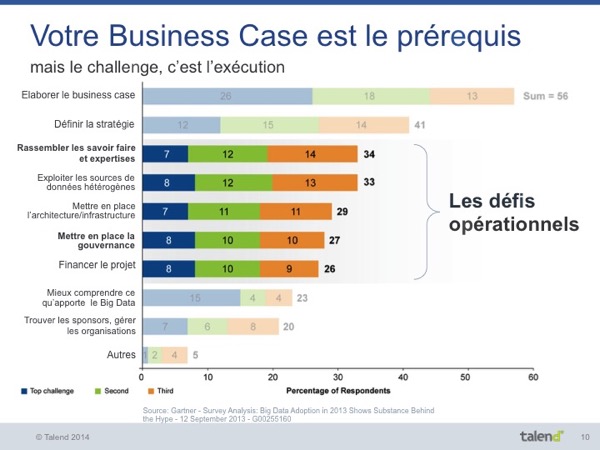

Les 5 défis majeurs du Big Data selon Talend

Cette méthode, pour efficace qu’elle soit, n’est rien sans une approche claire et pragmatique de la mise en œuvre de projet. En soi, cela ne surprendra pas les habitués, maîtres d’ouvrages ou maîtres d’œuvres des systèmes d’information. Certes, mais les défis en matière de Big Data restent spécifiques. Ils ont été décrits par Jean-Michel Franco et sont repris dans sa présentation PowerPoint incluse ci-dessus.

1) Les défis des compétences

A chaque apparition d’une nouvelle technologie, des difficultés se manifestent. Dès la création du Web les entreprises ont aussitôt cherché à trouver des compétences. Puis, elles se sont finalement aperçues que le Web était accessible à tous et ne nécessitait pas de compétences particulières. Néanmoins, pour que les employés apprennent et maîtrisent les outils de productivité de la même façon qu’il y a 15 ans, lorsque le Web est né, il va falloir se réinventer en permanence. On est amené avec cette technologie à passer d’un environnement à l’autre. Pour cela, il faut des outils, et notamment des générateurs de code.

2) Les défis de l’infrastructure

Il faut mettre en place cette infrastructure ou aller la chercher sur le Cloud. Le défi ici sera à la fois la capacité de montée en charge et l’intégration avec les SI existants.

3) Les défis des sources de données

L’innovation n’est pas dans les données traditionnelles, là, mais davantage dans les bases de données. Il faut ainsi trouver de nouvelles sources de données en les faisant remonter directement depuis le produit (par exemple, Coca-Cola met des capteurs dans ses distributeurs pour collecter les données au plus près du terrain) ;

Les données de l’extérieur : elles sont structurées mais, dans la grande majorité des cas, elles le sont d’une manière qui n’est pas celle qui intéresse l’entreprise qui les acquiert.

4) Les défis de la gouvernance des données

Un des principaux défis en matière de gouvernance des données consiste à en éviter les fuites, à protéger ces données ;

Il faut également en assurer la traçabilité et respecter les législations locales parfois complexes ;

Et enfin, superviser l’exploitation des données avec les Data Stewards (métadonnées).

5) Les défis économiques

Une entreprise peut décider de traiter toutes ses données mais il faut aussi maîtriser ses dépenses, des choix seront donc à faire.

Les bases de données traditionnelles ne fonctionnent pas avec les Big Data non plus, car elles sont peu capables de monter en charge. Un bon choix technologique (voire un bon mix de ces choix technologiques) est essentiel, comme nous l’avons décrit dans notre livre blanc des Big Data.

La maîtrise de ces cinq défis, alliée à un respect méthodologique du projet des Big Data permettra une mise en œuvre sûre et réussie.

![[Data Rider] Booster Mario Kart à l'IoT et à l'IA – Étape 3 : écoconduite et consommation électrique](https://fr.blog.businessdecision.com/wp-content/uploads/2024/08/data-rider-ecoconduite-1024x512-1.jpg)

Commentaire (1)

Votre adresse de messagerie est uniquement utilisée par Business & Decision, responsable de traitement, aux fins de traitement de votre demande et d’envoi de toute communication de Business & Decision en relation avec votre demande uniquement. En savoir plus sur la gestion de vos données et vos droits.

https://www.usine-digitale.fr/article/securite-et-qualite-des-donnees-freins-ou-opportunites-du-big-data.N328082