Le Big Data apparaît aujourd’hui comme une continuité logique et une évolution naturelle du décisionnel. Après avoir rappelé dans le précédent article les fondamentaux de la BI, cet article se propose de faire un retour sur les limites de la loi de Moore et l’impact sur les architectures décisionnelles. C’est le deuxième article d’une série de trois sur le thème « De la BI au Big Data ».

Accroissement des volumes

A la fin des années 90, il était commun d’analyser les ventes par magasin, à la journée et au groupe article (regroupement de produits), soit quelques milliers de lignes par jour. Aujourd’hui, les principales enseignes ont mis en place une carte fidélité et des programmes incitatifs personnalisés au client.

Pour ce faire, les enseignes analysent les ventes au détail du ticket de caisse ce qui peut représenter plusieurs dizaines de millions de lignes par jour sur une profondeur d’historique de 1 ou 2 ans. Les problèmes sont multiples tant au niveau de l’intégration qu’en restitution.

De fait, les entreprises ont rencontré des difficultés certaines pour contenir les durées de traitement dans les fenêtres batch de nuit et offrir des temps de réponse satisfaisants à leurs utilisateurs. Et ce malgré une révision à la hausse du dimensionnement des architectures décisionnelles. Pourquoi ?

Les limites de la loi de Moore

D’après la loi de Moore, le nombre de transistors des microprocesseurs sur une puce de silicium double tous les deux ans. Et ce qui est vrai pour le CPU, l’est également pour la RAM ou la capacité de stockage. C’est d’autant plus intéressant que les prix suivent une loi inverse rendant ces composants de plus en plus accessibles.

Alors pourquoi constatons nous des problèmes pour se projeter sur de grosses volumétries ? En fait, c’est relativement simple. Si les principales caractéristiques des ordinateurs ont une évolution qui suit la loi de Moore, ce n’est pas le cas du débit des disques durs.

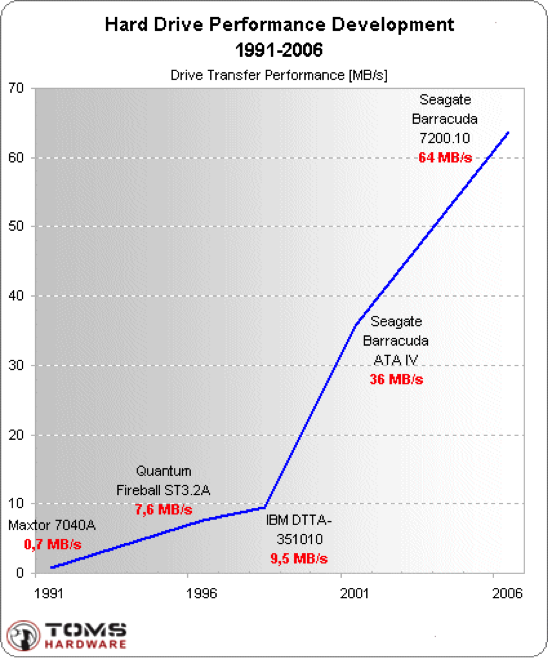

Evolution des débits disques sur 25 ans (source : Tom’s Hardware)

Sur 15 ans, la capacité de stockage est passée de 40 Mo à 750 Go (x 60000) quand dans le même temps le débit a simplement été multiplié par 100. Ce goulet d’étranglement que constitue le débit disque explique en grande partie l’émergence de nouvelles solutions pour remédier à ce problème.

Nous verrons dans le dernier billet de notre série « De la BI au Big Data » que le Big Data vise à répondre à un besoin plus large que la simple augmentation de la volumétrie et nous préciserons les solutions technologiques disponibles.

![[Data Rider] REX Collecte de données IoT – Étape 1 : Initier la collecte](https://fr.blog.businessdecision.com/wp-content/uploads/2025/05/data-rider-rex-collecte-donnees-1024x512-1.jpg)

Commentaires (3)

Votre adresse de messagerie est uniquement utilisée par Business & Decision, responsable de traitement, aux fins de traitement de votre demande et d’envoi de toute communication de Business & Decision en relation avec votre demande uniquement. En savoir plus sur la gestion de vos données et vos droits.

Quid de ces augmentations de performance avec les SSD? Aujourd'hui des constructeurs proposent des baies de disques ou des appliances avec plusieurs To de disques SSD.

Concernant l'intégration de SSD dans les appliances, je le vois pour ma part comme un composant haute performance dans une architecture MPP fortement scalable. Les appliances font d'ailleurs parties des solutions technologiques que je présenterai dans mon prochain billet.