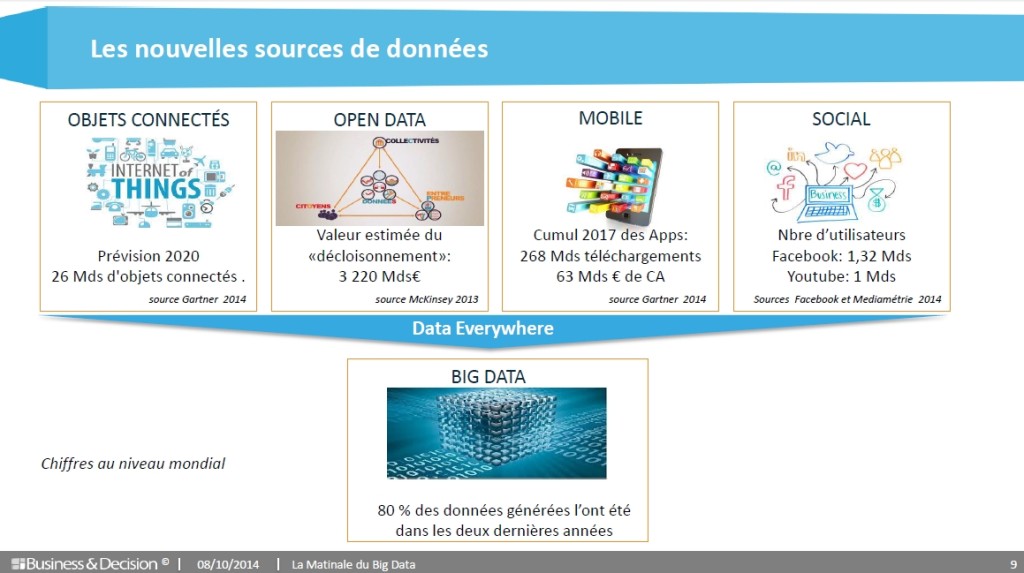

Depuis deux décennies, le flux d’informations croît à une allure exponentielle pour se transformer en un déluge de données. Cet article, premier d’une série de cinq articles dédiés au Big Data, pose les principes élémentaires du Big Data en formalisant les principaux enjeux et en proposant des repères.

Les innovations technologiques – sont nées du développement de canaux d’interactions omniprésents tels que Smartphones, mobiles, web, e-mails, réseaux sociaux et tablettes aujourd’hui, téléviseurs, voitures, maisons et tous les objets de la vie quotidienne demain. En 2014, ce sont 5 Zettaoctets de données qui peuvent être exploitées, et le rythme de croissance annuel moyen est de 40 % avec une prévision de 43 Zettaoctets en 2020. C’est le constat à l’origine du concept de Big Data ou mégadonnées en Français.

Les caractéristiques du Big Data

Ce volume vertigineux de données ne peut plus être collecté, stocké, géré et exploité par les solutions informatiques traditionnelles combinant infrastructures matérielles et bases de données relationnelles. En vue de trouver les solutions technologiques adéquates, une première phase de clarification conceptuelle du Big Data s’est imposée. Ainsi, des cabinets d’étude et d’analyse ont proposé la règle des 3V : Volume, Vélocité, Variété.

Volume

Dans les systèmes d’information en place dans les entreprises, les volumes de données traités se mesurent en téraoctets. Le challenge immédiat de l’IT traditionnel est d’être en capacité de traiter des Pétaoctets et bientôt des Exaoctets puis des Zettaoctets.

S’ensuivent une longue liste de questions auxquelles les spécialistes doivent apporter une réponse à plus ou moins long terme : quels sont les coûts ? Quels sont les outils de stockage et de traitement en temps réel ? Quelles sont les méthodes à adopter pour analyser l’information ? Quels sont les moyens pour archiver ? Les technologies émergentes proposent quelques débuts de réponse.

Vélocité

L’importance de l’immédiateté et de l’instantanéité pour recevoir ou émettre des informations par chacun d’entre nous et pour toutes les activités, professionnelles ou personnelles, du quotidien contraigne les organisations à améliorer leurs vitesses de réaction et d’anticipation. L’information n’est plus statique, mais elle devient un facteur de changement dynamique. Dans ce contexte, comment l’intégrer en temps réel dans les schémas de données actuels conçus pour être alimentés en temps différé ? Comment canaliser ce déluge d’information dans des flux maîtrisés ? Comment faire parvenir la bonne information au bon moment et au bon destinataire ?

Variété

Texte, images, photos, vidéos, quel que soit le format de l’information, les données, structurées ou non structurées, requièrent un nouveau savoir-faire pour être assimilées puis analysées. L’exploitation et le traitement de l’information aussi variée, tant par la forme que par le contenu, sont difficilement réalisables en dehors du support initial.

En conséquence, une approche d’indexation, de recherche sémantique et de navigation intra- et inter- applications s’impose pour l’exploitation de ces nouveaux médias, sans oublier la nécessité de modélisation de phénomènes complexes.

C’est précisément pourquoi la gouvernance des données, leur protection, la gestion de leur qualité constituent les nouveaux enjeux des systèmes d’information, puisque l’information ne provient pas nécessairement de sources internes et contrôlées et qu’elle ne correspond pas à priori et nécessairement aux caractéristiques attendues en termes de format, de qualité et d’intégrité.

Après les 3V…

Les cabinets d’étude et de conseil en marketing sont très actifs sur les marchés qui embarquent les nouvelles technologies. De nombreux qualificatifs sont venus s’ajouter aux 3V tels que Véracité, Valeur, Variabilité, auxquels sont associées des notions de compétences et de coûts. Répondre aux caractéristiques des 3V, dans les premières mises en place de systèmes d’information, est déjà un challenge. Il convient néanmoins de n’écarter aucune dimension dans l’analyse, en particulier la notion de Véracité.

Dès la mise en œuvre des premiers entrepôts de données, dans les années 1990, la question de la véracité et de la qualité de la donnée a été un enjeu majeur. Aux Etats-Unis, le théorème « garbage in, garbage out » s’est immédiatement répandu. Il n’y a donc rien de nouveau sur ce qualificatif : seule une donnée de qualité va permettre de produire un événement, une prévision ou une information réaliste et de définir un levier d’action. La conciliation des données internes et externes a toujours été un défi. L’histoire a montré que l’information de la meilleure qualité n’est pas toujours celle issue des systèmes d’information de l’entreprise.

Opportunités et incertitudes

Une fois les contraintes et le cadre posés, « Big Data » signifie-t-il « Big Opportunités » ? Comment tirer toute la valeur de cette masse énorme de données que la technologie met à disposition ? Le plus grand risque serait de bâtir les projets de Big Data sur des socles d’infrastructures ou de méthodologies existantes et employées sur les projets de Business Intelligence. Si on applique les usages d’analyse de données utilisés par les utilisateurs de la BI d’entreprise au « Big Data », comment peut-on alors obtenir un retour sur investissement rapide en regard des investissements nécessaires pour construire l’infrastructure initiale ?

Compte tenu de la masse d’informations à la disposition des utilisateurs, les approches de Big Data devraient constituer le mode privilégié de prise de décision dans l’entreprise : elles fournissent le maximum de données pour étayer les analyses, évaluer les tendances et, par conséquent, conforter les décisions. Une nouvelle opportunité surgit néanmoins de l’analyse des masses d’information. Il s’agit d’aller à la source pour repérer la naissance d’un dysfonctionnement ou d’un problème. Et d’orienter les décisions vers un axe non seulement prédictif mais également préventif.

La prévention comme maître-mot

Un parallèle peut ainsi être établi avec le monde de la médecine. En effet, il ne s’agit pas seulement de guérir, mais également d’éviter la maladie. Dans cet esprit, et en transposant le principe dans le monde digital, il s’agit d’aller à la source de l’information, de repérer les rumeurs et d’en identifier les causes et l’origine. Cela est souvent plus complexe à mettre en évidence que le problème.

Les 3V du Big Data ouvrent alors un nouvel univers, celui de l’analyse de phénomènes complexes où il y a besoin de compétences multiples et complémentaires : mathématiques et informatique, mais également psychologiques, sociologiques ou anthropologiques. C’est bien le croisement des sciences qui fera la richesse des modèles d’analyse.

De profonds bouleversements au sein des entreprises

L’émergence du Big Data amène également de profonds bouleversements au sein même des organisations et des entreprises. Alors qu’il existe des structures dédiées à la gestion des ressources humaines, à la finance, ou à la gestion du capital client, comment s’organiser pour exploiter et protéger le capital informationnel indépendamment des organisations fonctionnelles ? Comment les processus, les acteurs et les organisations peuvent-elles (re)devenir agiles pour répondre au challenge de l’analyse en juste-à-temps, ou à minima, pour diminuer les temps de latence inhérents à leur fonctionnement ?

En effet, un Tweet sur une rumeur met quelques heures pour faire le tour de la planète. En retour, la réaction des entreprises met plusieurs jours voire plusieurs mois pour intervenir et encore plusieurs années pour effacer la rumeur. La multiplication des sources et l’immédiateté caractérisant les informations disponibles sur le web sont les phénomènes encore nouveaux auxquels désormais l’entreprise doit faire face.

Un champ immense d’investigation s’offre donc à nous si nous savons construire de nouveaux édifices fondés sur des réflexions nouvelles. Voilà sans doute un des plus grands enjeux du Big Data : un vaste océan d’opportunités qu’il va falloir apprendre avant tout à canaliser et à mettre au service des bons cas d’usage.

![[Data Rider] REX Collecte de données IoT – Étape 1 : Initier la collecte](https://fr.blog.businessdecision.com/wp-content/uploads/2025/05/data-rider-rex-collecte-donnees-1024x512-1.jpg)

Votre adresse de messagerie est uniquement utilisée par Business & Decision, responsable de traitement, aux fins de traitement de votre demande et d’envoi de toute communication de Business & Decision en relation avec votre demande uniquement. En savoir plus sur la gestion de vos données et vos droits.