68 % des employés utilisent ChatGPT au travail dans le dos de leur employeur. Ce sont donc plus de 2 entreprises sur 3 qui partagent des données personnelles ou confidentielles avec une application publique non protégée. Un constat alarmant qui offre l’occasion de poser la question des considérations éthiques et légales de l’IA générative, et plus largement de l’IA de confiance. Quels risques un usage non maîtrisé de l’IA générative peut-il entraîner pour l’entreprise ? Quelques éléments de réponse dans cet article.

Matinale Data & IA

La question de l’éthique de l’IA dépasse amplement les murs de l’entreprise et recouvre de nombreux enjeux sociétaux tels que les risques désinformation, d’uniformisation de la pensée, les dégâts sociaux des travailleurs du clic ou encore ceux de l’écologie. Si ces questions sont au cœur du débat de l’émergence de ces IA génératives, il est impossible de toutes les traiter ici. Aussi, ce chapitre propose de se concentrer sur les questions éthiques à prendre en compte par les entreprises lorsqu’elles déploient des applications d’IA générative.

C’est quoi l’éthique de l’IA ?

Le terme éthique provient directement de la philosophie. Si on s’en tient à la définition donnée par le dictionnaire de l’Académie française, il s’agit de :

- Réflexion relative aux conduites humaines et aux valeurs qui les fondent, menée en vue d’établir une doctrine, une science de la morale.

- Ensemble des principes moraux qui s’imposent aux personnes qui exercent une même profession, qui pratiquent une même activité.

Toutefois, l’éthique étant intrinsèquement liée aux valeurs et à la culture de chaque groupe humain, il est impossible de déterminer de façon absolue si une IA est « bonne » ou « mauvaise ». En effet, cette perception est forcément liée à la culture du pays dans laquelle elle est appliquée, ainsi qu’au vécu et à l’expérience de chaque individu ou à de nombreux autres facteurs personnels.

C’est cela qui rend ce sujet complexe et en réalité hautement philosophique !

Pour les applications de l’IA dans l’entreprise, il faudra aborder la question éthique sous l’angle de l’acceptabilité. Où est-ce que l’application de l’IA est acceptable pour un groupe d’utilisateurs ? Quelles sont les conditions de déploiement pour qu’elle soit acceptable ? Quelles sont les limites et garde-fous à déployer pour la rendre acceptable ? Toutes ces questions sont à se poser en les appliquant au groupe d’utilisateurs ou de personnes exposés aux usages de l’IA.

Pourquoi se poser cette question de l’IA de confiance ?

Les Français figurent parmi les plus sceptiques concernant l’intelligence artificielle :

- Seuls 31 % lui font confiance, loin derrière les 75 % d’Indiens par exemple ;

- 53 % estiment par ailleurs que les IA constituent un risque important pour la sécurité des données ;

- Et la moitié estime qu’elle est un enjeu de taille pour les droits d’auteur et la propriété intellectuelle.

La confiance en l’IA, et par extension en l’IA générative, se trouve ainsi diluée dans des questions cruciales d’éthique et de responsabilité juridique mixées à des craintes irrationnelles drainées par les œuvres de science-fiction et par les médias qui font leurs choux gras d’annonces sensationnalistes mais en réalité peu sérieuses.

68 % des Français s’inquiètent de l’émergence des IA génératives.

Source : Enquête Les Français et les IA génératives, Ifop pour Talan, mai 2023

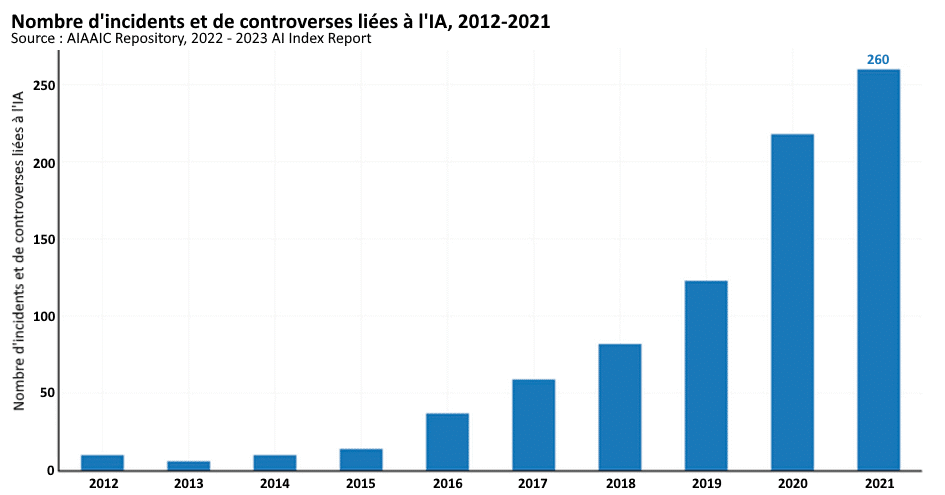

S’il faut donc savoir repérer les sujets véritablement importants, on constate que le nombre d’incidents liés à des dérives non éthiques de l’IA explosent. Selon la base de données AIAAIC, qui les répertorie au niveau mondial, le nombre d’incidents et de controverses liés à l’IA a été multiplié par 26 entre 2012 et 2021, passant d’une dizaine à 260 incidents recensés. Parmi eux, de nombreux « deepfakes » mais aussi des problèmes liés aux biais inclus dans les données d’entraînement.

Avec des risques qui deviennent donc de plus en plus nombreux et concrets pour les individus exposés, les entreprises doivent prendre le sujet au sérieux et l’intégrer au cœur des projets d’IA générative.

L’AI Act, socle européen de l’IA de confiance

À l’image du règlement général sur la protection des données personnelles (RGPD), l’Europe aspire à être pionnière concernant la réglementation des usages de l’IA. Elle travaille ainsi depuis plusieurs années sur un ambitieux projet de règlement qui a été validé par le Parlement européen le 14 juin 2023, ouvrant la voie à la mise en œuvre d’un cadre juridique pour les usages de l’IA.

Les entreprises auront ainsi à classifier tous leurs usages de l’IA selon leur niveau de risque éthique :

- Minime ;

- Limité ;

- Élevé ;

- Inacceptable.

Avec ce règlement, l’Europe fixe une ligne claire vis-à-vis d’usages à très fort impact social et sociétal et se démarque de certaines autres régions du monde telles que la Chine qui fait grand usage de la reconnaissance faciale ou de la notation sociale par exemple.

En regard du niveau évalué pour chaque application d’IA, l’entreprise devra associer des mesures de réduction de risque appropriées. La mise en conformité à l’AI Act peut donc démarrer dès maintenant par un recensement et une classification de tous les usages à l’échelle de l’entreprise. Les principes de l’ethics-by-design (ou éthique par construction en Français) sont ainsi à instaurer pour tenir compte de ces problématiques à chaque étape des projets. Nous les avons d’ailleurs placé au cœur de notre méthodologie de construction et de déploiement de l’IA.

Les trois plaies de l’IA

L’IA de par son mode de fonctionnement, lié à l’apprentissage machine, présente des problématiques intrinsèques. Celles-ci ne trouvent pas toujours de solution évidente mais elles doivent être connues et évaluées pour promouvoir des algorithmes de confiance.

L’enjeu d’équité

Qui dit données d’entrainement, dit inévitablement risque de biais, notamment vu le volume phénoménal de données nécessaires pour entraîner les modèles d’IA générative. En témoigne la liste des sites sur lesquels ChatGPT a été entraîné qui illustre clairement le manque de diversité culturelle et de représentativité de populations ou de courants de pensée. A titre d’exemple, la start-up américaine Textio a mis en évidence de multiples biais sociaux (liés à l’âge, au genre ou à l’origine ethnique) lors d’un test de rédaction de 167 annonces d’emploi par ChatGPT.

Les biais algorithmiques sont ainsi étroitement liés au manque de diversité et d’inclusion dans les bases de données utilisées. Pour développer une IA de confiance, il est nécessaire (mais pas forcément suffisant) d’une part, de réaliser des tests statistiques poussés sur les données d’entraînement, et d’autre part, d’accroître la diversité et l’inclusion dans la tech pour élargir les profils des développeurs IA : mixité, diversité culturelle, formations différentes, ouverture sociale, etc.

L’enjeu de transparence

En matière de transparence, il est nécessaire de respecter un premier principe basique. Celui de ne jamais créer de confusion sur l’interlocuteur dans un dialogue entre un humain et une IA. L’utilisateur doit ainsi systématiquement savoir qu’il est face à une IA. Ce devoir d’information est essentiel et constitue la base du principe de transparence d’usage.

Une autre problématique est celle du manque d’explicabilité des décisions et contenus générés par les IA. Ces IA reposant sur des modèles de type « Transformer » avec des réseaux de neurones étendus et complexes les rendent opaques et compliquent la détection de leurs « hallucinations » (des réponses fausses présentées de façon si vraisemblable qu’elles peuvent être considérées comme avérées).

C’est pourquoi les entreprises doivent être en mesure d’expliquer pourquoi et comment l’IA prend ses décisions. De quelle façon ? En précisant par exemple quelles sources d’information ont été utilisées pour composer la réponse. Cette notion d’explicabilité des décisions de l’IA est essentielle pour satisfaire les principes éthiques et fait partie intégrante des sujets de transparence de l’IA.

L’enjeu de responsabilité

L’entreprise reste pleinement responsable des IA qu’elle déploie, y compris d’un point de vue juridique, et par conséquent, des décisions de ses solutions d’IA. Elle accepte donc d’endosser le risque d’amplification d’un problème éthique lié à la capacité d’automatisation extrême de l’IA. C’est pourquoi plus tôt elle intègrera la dimension éthique dans le développement de ses IA, plus elle limitera les risques.

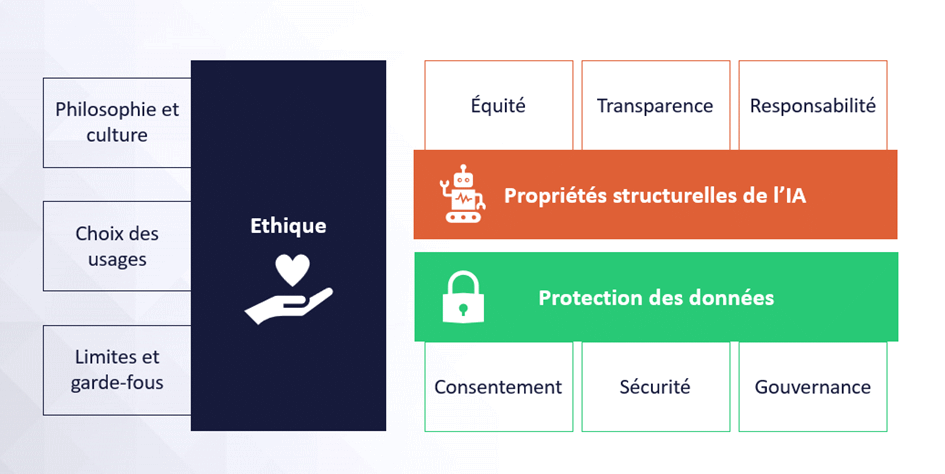

On le voit, le sujet de l’éthique en IA couvre plusieurs domaines. La base, c’est la protection des données et donc, a minima, la conformité au RGPD. Sans protection des données personnelles, on ne peut pas prétendre établir une IA de confiance. Ensuite, il faut s’intéresser aux propriétés structurelles de l’intelligence artificielle, notamment celles de l’équité et la transparence, qui doivent être adressées par les data scientists qui établissent les algorithmes. Enfin, l’éthique est finalement avant tout une question philosophique. Chaque entreprise va alors devoir choisir les champs d’application et usages, ainsi que définir les limites et garde-fous à mettre en œuvre.

L’impact environnemental de l’IA

Un autre sujet à considérer dès lors que l’on veut développer une IA respectueuse est celui de son empreinte environnementale. En effet, l’entraînement et l’exploitation des IA génératives impliquent nécessairement d’importants moyens pour le stockage des données et les calculs algorithmiques qui ont inévitablement un fort impact environnemental.

D’où l’intérêt d’utiliser systématiquement les algorithmes pré-entraînés (GPT signifie d’ailleurs Generative Pre-trained Transformers) et de les adapter pour les cas d’usage spécifiques de l’entreprise (par exemple en utilisant le transfer learning), évitant ainsi de réentraîner des milliards de données pour chaque solution d’entreprise. Le gigantesque coût environnemental de l’entraînement des IA génériques (telles que GPT, Bard et consorts) est alors dilué pour servir des millions d’usages à l’échelle mondial. Par ailleurs, certaines approches algorithmiques en cours de développement permettent d’envisager des algorithmes aussi efficaces mais moins impactants pour l’environnement.

IA frugale et écoconception des algorithmes d’IA

Le concept de frugalité a été lancé en 2019 à travers le plaidoyer de chercheurs de l’Allen Institute for AI en faveur d’une IA frugale ou green AI, c’est-à-dire une IA plus efficace et plus inclusive, et moins gourmande en données et en énergie (liée à la puissance de calcul). Or, la quantité astronomique de données utilisées pour entraîner les IA génératives de type ChatGPT participe à augmenter l’empreinte carbone du numérique. Les entreprises doivent intégrer le concept de frugalité à leurs processus pour déployer une IA vertueuse, moins consommatrice.

C’est pourquoi, chez Business & Decision, nous appliquons les principes d’écoconception dans notre méthodologie. Pour en savoir plus, consultez notre livre blanc MLOps : un regard vers le futur de l’IA.

💡 Quelles actions concrètes ?

Toute démarche d’IA générative doit donc prendre en compte de multiples sujets liés à la confiance, la sécurité, l’éthique. Que ce soit pour la mise en conformité à la réglementation AI Act ou pour garantir la meilleure utilisation, toutes ces questions sont à placer au cœur de vos démarches de déploiement de l’IA.

On vous propose de retenir 12 actions concrètes qui sont prioritaires pour le déploiement d’IA de confiance dans l’entreprise.

6 actions que peuvent mettre en œuvre les Data Scientists et les professionnels de la Data et de l’IA :

- Instaurer les principes d’Ethics-by-design

- Profiler les données d’apprentissage pour confirmer leur représentativité

- Tester et valider les algorithmes sur des critères éthiques

- Auditer les IA en production sur des critères éthiques

- Adopter la sobriété algorithmique et les principales de l’IA frugale

- Signer le Serment d’Hippocrate du Data Scientist (ou équivalent)

6 actions qui doivent être portées par l’entreprise :

- Respecter le RGPD et l’AI Act

- Nommer un Chief Ethics Officer

- Établir une Charte de Confiance et d’Éthique

- Acculturer aux enjeux et risques de l’IA

- Être transparent sur l’usage de l’IA vis-à-vis des utilisateurs

- Garder la capacité de reprendre la main sur l’IA

👉 Retrouvez toute notre actu en temps réel en nous suivant sur LinkedIn 👈

![[Data Rider] Booster Mario Kart à l'IoT et à l'IA – Étape 3 : écoconduite et consommation électrique](https://fr.blog.businessdecision.com/wp-content/uploads/2024/08/data-rider-ecoconduite-1024x512-1.jpg)

Votre adresse de messagerie est uniquement utilisée par Business & Decision, responsable de traitement, aux fins de traitement de votre demande et d’envoi de toute communication de Business & Decision en relation avec votre demande uniquement. En savoir plus sur la gestion de vos données et vos droits.